Bài viết gần đây

-

-

Áp Dụng BOT Vào Phân Tích Và Đầu Tư Chứng Khoán Hiệu Quả

Tháng 2 15, 2026

| Xử lý load lớn cho Webhook & WebSocket: Queue, Redis & Scaling

Được viết bởi thanhdt vào ngày 27/01/2026 lúc 23:59 | 28 lượt xem

Khi ứng dụng của bạn bắt đầu đón nhận hàng nghìn, thậm chí hàng triệu sự kiện mỗi giây từ các nguồn Webhook hoặc hàng chục nghìn kết nối WebSocket đồng thời, các phương pháp triển khai thông thường sẽ nhanh chóng bị “nghẽn cổ chai”.

Làm sao để hệ thống vẫn chạy mượt mà khi traffic tăng đột biến? Làm sao để đồng bộ tin nhắn giữa nhiều server khác nhau? Bài viết này sẽ hướng dẫn bạn các kỹ thuật Scaling (Mở rộng) và Queueing (Hàng đợi) chuyên sâu để xây dựng một Backend “bất bại”.

| Vấn đề | Giải pháp | Công nghệ |

|---|---|---|

| Nghẽn Webhook | Xử lý bất đồng bộ qua Hàng đợi | BullMQ, Redis |

| Đồng bộ WebSocket | Pub/Sub cho nhiều Instance | Redis Adapter |

| Quá tải CPU/RAM | Mở rộng hàng ngang (Horizontal Scaling) | Docker, Kubernetes, Nginx |

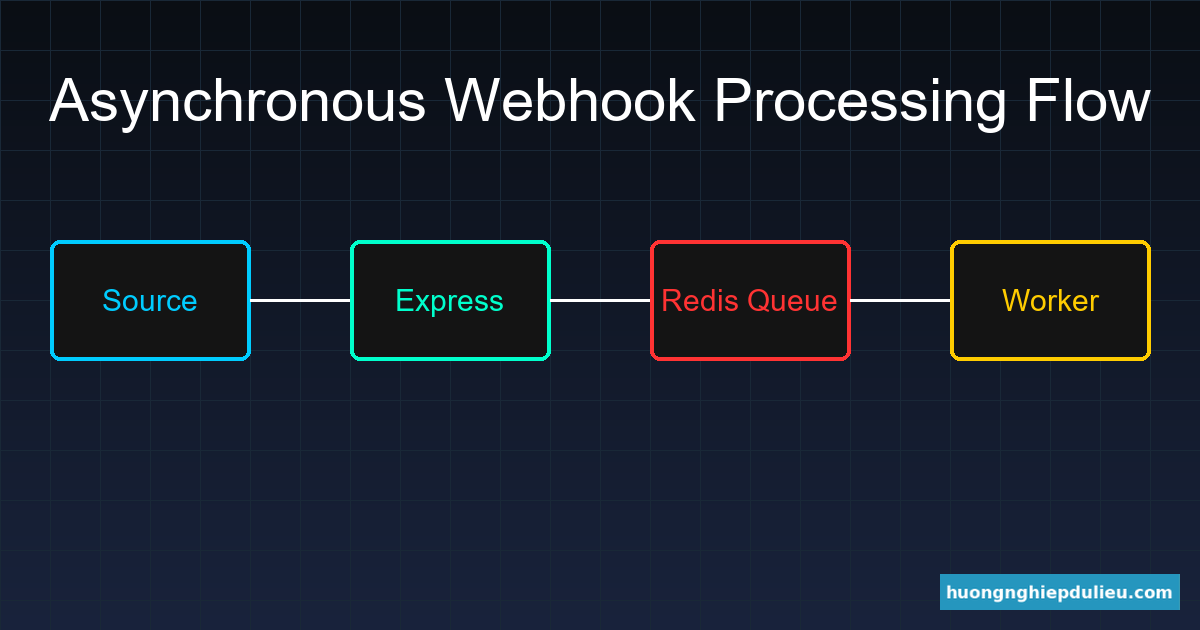

1. Xử lý nghẽn Webhook bằng Message Queue

Khi một Webhook gửi dữ liệu tới, nếu bạn thực hiện lưu Database, gửi Email, và gọi API bên thứ ba ngay lập tức, Request đó sẽ tốn rất nhiều thời gian để hoàn thành. Nếu hàng nghìn request cùng đến, Event Loop của Node.js sẽ bị chặn.

Giải pháp là sử dụng mô hình Producer – Consumer với hàng đợi Redis.

- Express (Producer): Nhận Webhook, đẩy dữ liệu vào Hàng đợi và trả về 200 OK ngay lập tức.

- Redis: Lưu trữ tạm thời các công việc (Jobs) cần làm.

- Workers (Consumers): Các tiến trình chạy ngầm sẽ lấy Job từ Redis và xử lý dần dần.

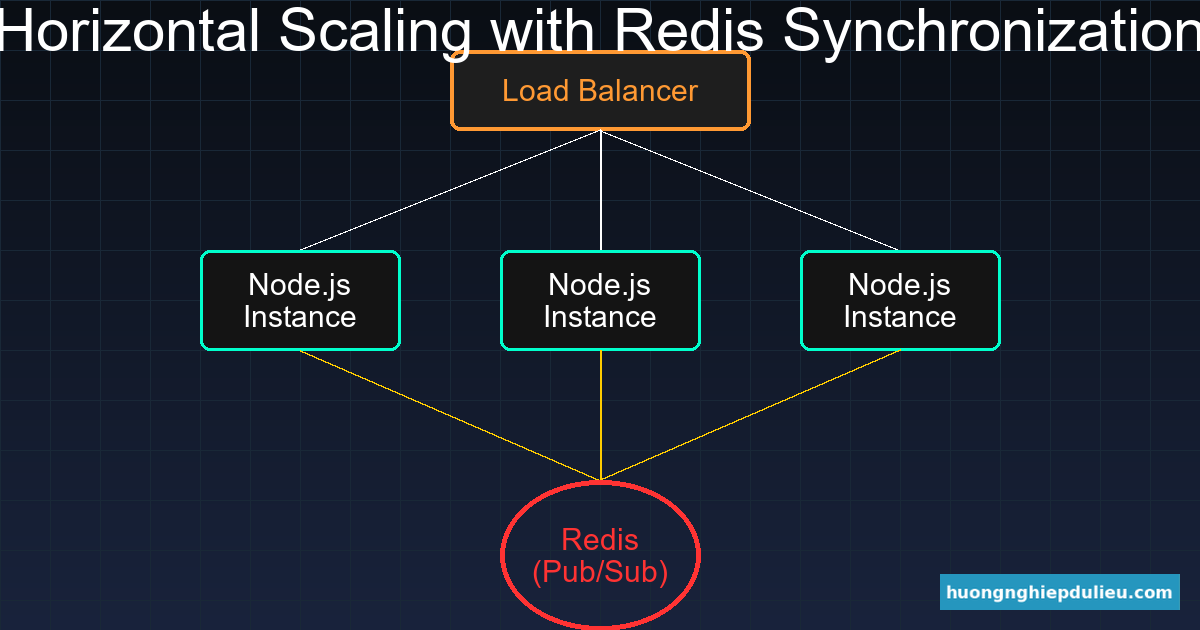

2. Horizontal Scaling cho WebSocket với Redis Pub/Sub

WebSocket là kết nối có trạng thái (Stateful). Nếu bạn chạy 2 server Node.js sau một Load Balancer, người dùng A kết nối tới Server 1 sẽ không thể nhận được tin nhắn từ người dùng B kết nối tới Server 2.

Để giải quyết vấn đề này, chúng ta cần một lớp trung gian để đồng bộ tin nhắn.

Sử dụng @socket.io/redis-adapter, khi Server 1 muốn phát một tin nhắn, nó sẽ đẩy tin nhắn đó vào Redis. Redis sau đó sẽ “phát loa” tới tất cả các server Node.js khác để đảm bảo mọi Client đều nhận được dữ liệu.

3. Triển khai code: Cấu hình Redis Adapter

Việc cấu hình này cực kỳ đơn giản nhưng mang lại khả năng mở rộng không giới hạn:

const { Server } = require("socket.io");

const { createClient } = require("redis");

const { createAdapter } = require("@socket.io/redis-adapter");

const pubClient = createClient({ url: "redis://localhost:6379" });

const subClient = pubClient.duplicate();

Promise.all([pubClient.connect(), subClient.connect()]).then(() => {

const io = new Server(server, {

adapter: createAdapter(pubClient, subClient)

});

io.on("connection", (socket) => {

// Giờ đây mọi socket.emit sẽ được đồng bộ qua Redis

console.log("Socket connected to instance");

});

});

4. Stateless Backend: Chìa khóa để Scaling

Để mở rộng hệ thống dễ dàng, hãy đảm bảo Backend của bạn là Stateless:

– Đừng lưu Session trong bộ nhớ của Node.js (dùng Redis/JWT thay thế).

– Đừng lưu file trực tiếp trên ổ cứng của server (dùng Cloud Storage như S3/Cloudinary).

– Sử dụng PM2 Cluster Mode để tận dụng tối đa các Core CPU trên cùng một máy chủ.

Hệ thống của bạn giờ đây đã sẵn sàng chịu tải hàng triệu người dùng. Nhưng code càng phức tạp, việc phát hiện lỗi càng khó khăn.

Bài tiếp theo: Debug & test Webhook / WebSocket trong Node.js.

Đừng quên tham khảo checklist quyết định: Khi nào nên dùng Webhook, khi nào dùng WebSocket?

💡 Bạn muốn học cách xây dựng hệ thống Trading Scalable chịu tải hàng vạn người dùng?

Tìm hiểu thêm tại: Phân tích kỹ thuật & Chiến lược xu hướng VIP